劉烱德分析師像你鄰家好大叔

在金融市場30年資歷,講盤有理路且淺顯易懂。

敢於判定走勢多空方向外,擅長運用技術分析預先掌握關鍵價位,且能在關鍵未出現明確多空訊號時,同時交易操作空間符合「盈虧2:1」時,才會執行交易。

擅長設定移動停利,由短做長。潛力股的基本面及技術面教學,能讓市場投資人驗證及學習。

台股攻略掌握方向 抓住趨勢,戰勝多空轉折大叔帶你攻略台股!

畫線、定價、到實戰,實現獲利看的見!

著作:

連「渡邊太太」都想學的 K線匯率課

烱大叔的YT頻道,每天都有畫線、定價,影音教學

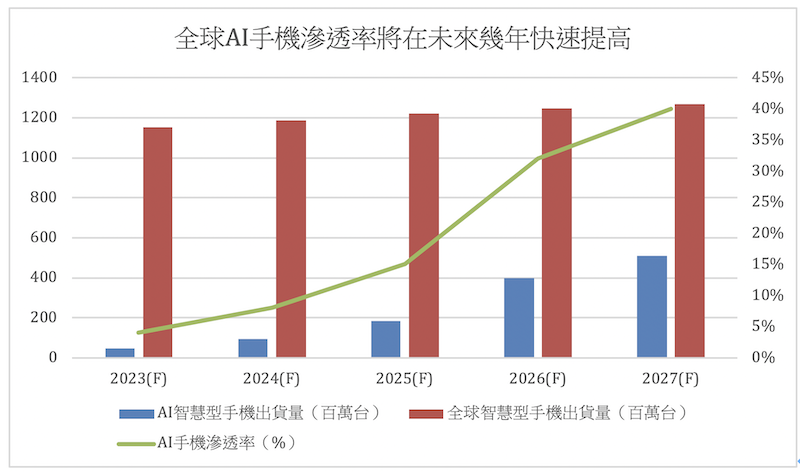

隨著主要的手機AP晶片廠開始大力推出手機AI晶片產品之際,國內也有研調機構開始看好全球AI智慧型手機滲透率將在未來幾年快速提高。從數據上來看,2023年全球AI手機出貨量約落在4,600萬至4,700萬支,到了2027年將提高到5億1,000萬至5億2,000萬支,年均複合增長率高達80%以上;至於滲透率方面,2024年AI智慧型手機占整體智慧型手機的滲透率將來到8%,2025年會提高到15%,2026年則是32%,2027年更一舉來到40%,AI智慧型手機的成長趨勢已經非常明確。

資料日期:2024.01 資料来源:富邦投顧

圖片放大

AI手機爆發下的台廠商機

在AI智慧型手機滲透率快速提高的同時,台灣廠商的商機何在呢?其實,現階段除了手機AP業者摩拳擦掌之外,記憶體產業也即將迎來近幾年的最大商機。進一步解析,目前大部分的語言模型都是放在雲端上去計算,用戶透過設備連網後,再從雲端取得運算後的結果。但是,市場上已經開始考量到AI手機的隱私權、個人資料保護、裝置安全防護等問題,因此,有一種聲音是要求把大型語言模型直接塞到你我的手機裡;也就是說,不靠雲端的算力,純粹用手機內建的晶片去跑模型。

然而,用手機去執行AI這件事到底有多困難呢?首先,大家要有個概念,目前主流的手機記憶體容量約落在8GB到16GB,可是,如果參考聯發科的說法,330億個參數的大語言模型要占33GB的記憶體,加上手機本身跑Android系統就要3GB至4GB的記憶體,因此總共約需要37GB的記憶體,已經是現行容量的2倍以上,這還不包括下載其他App時,所需要用到的記憶體。不僅如此,就算採用聯發科自家所推出的記憶體硬體壓縮技術,以軟體壓縮率60%以上概算,330億個參數的大語言模型壓縮後,將吃24GB的記憶體,由此可見現行的16GB記憶體完全不夠用。

至於高通的產品,目前業界普遍認為,要發揮最新AP晶片驍龍8 Gen 3的全部性能,手機最好要搭配24GB的記憶體,這同樣也比現行的16GB多了8GB,因此,AP業者幾乎一致認定,記憶體未來在手機的使用數量將會大幅提高。

不僅如此,目前最夯的AI伺服器,為了加快運算速度,同時降低延遲,需要把更強大的模型與參數,保留在離核心運算更近的位置,因此,最重要的GPU晶片還會使用到超高頻寬的記憶體,也就是大家常聽到的HBM。研調機構顧能也預估,全球HBM的營收規模,將在2023年至2025年出現非常快速的成長,年增率分別高達82.1%、65.5%,以及50%。

大叔先來幫大家簡單地科普一下,HBM記憶體算是由DRAM堆疊後,再透過3D IC先進封裝而成的產物,在密度增加的同時,讓體積可以維持不變,甚至還更小,以此達到更好的儲存效果,不過,生產HBM會耗費記憶體廠商較大的產能。用數據來講,如果同時用一個單片晶圓分別生產DDR記憶體與HBM記憶體,以生產的顆粒數來說,DDR將比HBM高出2.7倍至3.4倍。